Racismo en la IA: un problema más allá de la tecnología La inteligencia artificial promete redefinir nuestra cotidianidad, inaugurando una era tecnológica que, para muchxs, parece sacada de la ciencia ficción. Sin embargo, este horizonte de innovación no está libre de controversias. Entre ellas, el racismo se perfila como un desafío crítico, incrustado en los algoritmos que son el corazón de estos sistemas avanzados.

La inteligencia artificial promete redefinir nuestra cotidianidad, inaugurando una era tecnológica que, para muchxs, parece sacada de la ciencia ficción. Sin embargo, este horizonte de innovación no está libre de controversias. Entre ellas, el racismo se perfila como un desafío crítico, incrustado en los algoritmos que son el corazón de estos sistemas avanzados.

Imagina ser una mujer afrodescendiente, ansiosa por descubrir cómo lucirías inmersa en el colorido y emblemático ambiente de los años 80.

Pese a tus reservas sobre compartir datos biométricos, te aventuras a utilizar una herramienta de IA en Facebook diseñada para proyectarte en aquel contexto retro. Sin embargo, el resultado te desconcierta: no solo distorsiona tus características faciales, sino que, de manera inesperada, aclara tu piel. Impulsada por la intriga, decides extender el experimento a imágenes de tus familiares de piel más oscura y descubres que la aplicación tiende a «blanquear» sistemáticamente a las personas con fenotipo afro. ¿Cuáles son las implicaciones del sesgo racial inherente en la tecnología de la IA?

¿Dónde está el sesgo racial en la IA?

Un análisis reciente del Instituto Nacional de Estándares y Tecnología (NIST) en Estados Unidos ha revelado que los sistemas de reconocimiento facial basados en IA no identifica de manera precisa a individuos de ascendencia afrodescendiente y asiática. Al revisar 189 algoritmos de 99 desarrolladores distintos, incluidas firmas destacadas como Microsoft, Intel y SenseTime, se ha evidenciado que erradicar el sesgo racial de estas tecnologías es un desafío pendiente.

Según Juan David Gutiérrez, especialista en políticas públicas e IA y profesor en la Universidad de los Andes, la IA identifica personas usando dos enfoques clave. El caso anterior da cuenta de dos métodos. El método «uno a uno» que compara dos fotos diferentes de la misma persona para comprobar su identidad, útil en tareas como la verificación de pasaportes o el desbloqueo facial en celulares. Y el método «uno a muchos», que busca coincidencias entre una foto y muchas otras en una base de datos, crucial para identificar sospechosos en investigaciones criminales.

Un ejemplo de sesgo racista en el método “uno a muchos” lo reportó el medio DW. En su informe, revelaron cómo un sistema de IA logró identificar correctamente un termómetro infrarrojo sostenido por una mano blanca, pero lo confundió con una pistola cuando fue sostenido por una mano negra. Este caso ilustra la capacidad de la IA para manifestar los sesgos de sus creadores y las tendencias presentes en los conjuntos de datos utilizados para su entrenamiento. Juan de Brigard1, investigador de estos temas, argumenta que este fenómeno pone de manifiesto la falta de imparcialidad en la IA: su eficacia y precisión pueden verse influenciadas por las características demográficas predominantes en los datos de entrenamiento. Así, una herramienta de reconocimiento facial desarrollada en el norte global podría basarse en datos que no representan adecuadamente a todas las etnias, limitando su efectividad al identificar a personas de grupos raciales menos representados.

Diana Montenegro, abogada, magister en regulación de plataformas digitales y ética de la IA, propone una estrategia crucial para superar este reto: promover la diversidad en los equipos de desarrollo de IA. Argumenta que un equipo conformado exclusivamente por hombres blancos de ciertas condiciones socioeconómicas probablemente diseñará sistemas que reflejen un espectro limitado de perspectivas, introduciendo sesgos en la IA. Por contraste, equipos compuestos por una variedad de experiencias y puntos de vista están en mejor posición para desarrollar tecnologías equitativas y representativas.

Los desaciertos de la IA: una carga desigual

La IA está en el umbral de un cambio significativo en la representación y el tratamiento de la diversidad. De Brigard arroja luz sobre una inquietud creciente: las personas con características fenotípicas menos representadas en los conjuntos de datos, como las mujeres afrodescendientes, enfrentan los mayores desafíos debido a los sesgos inherentes en estos sistemas avanzados. Este problema se hace evidente en el estudio «Gender Shades» de Joy Buolamwini del MIT Media Lab, en donde muestran cómo la precisión de reconocimiento facial disminuye cuando se trata de mujeres de piel oscura –en comparación con hombres de piel clara–, revelando una notable falta de representatividad en los datos utilizados para el entrenamiento de IA.

Este dilema no surge de malas intenciones en la concepción de los algoritmos. Por el contrario, Gutiérrez señala que, incluso con las mejores intenciones, las aplicaciones de IA pueden perpetuar desigualdades. Los sistemas tecnológicos, al ser empleados para amplificar o consolidar el poder, pueden impactar de manera desigual a distintos sectores sociales. Un ejemplo de esto es lo que sucedió con Gemini, la IA de Google.

Gemini y el espejo de la diversidad

En febrero, Google presentó «Gemini», una innovación significativa en su cartera de IA, diseñada para transformar texto en imágenes detalladas con rapidez (la competencia de Midjourney o DALL-E). Rápidamente lxs usuarixs identificaron fallos incluso en la representación de personas blancas. Gemini arrojó imágenes que representaban a nazis de diferentes razas.

Esto desató intensos debates acerca de la orientación ideológica de Gemini, con críticas apuntando a que podría ser «demasiado progresista». El incidente avivó conversaciones críticas sobre la discriminación histórica –¿hubo personas de ascendencia africana que fueron nazis?– y puso en cuestión el enfoque adoptado por Google en el desarrollo de esta tecnología.

Hablar con la máquina: anhelos y temores de la IA generativa

Con la llegada de Sora, el nuevo modelo de IA generativa que crea videos a partir de textos, quedó en evidencia que la industria creativa necesita replantear algunas cuestiones. Sobre todo, cuando el arte y la técnica se adentran cada vez más en el mundo digital.

Click acá para verGutierrez explica que “Gemini introdujo una función innovadora que reescribe las instrucciones del usuario para mejorar la generación de imágenes. Por ejemplo, al solicitar una imagen de un ‘Papa’, el sistema podría modificar la solicitud para aumentar la diversidad en el resultado, intentando incluir distintos grupos sociales o tonos de piel. Este mecanismo no se basa solo en los datos, sino que ajusta la ponderación de ciertos elementos mediante su algoritmo”. El propósito era ofrecer resultados más precisos y menos sesgados, reflejando el compromiso de Google con la inclusión.

De Brigard explica que “los algoritmos pueden estar sesgados no por su diseño inicial, sino por las bases de datos usadas en su entrenamiento. Cuando estos datos no reflejan la diversidad real, los algoritmos pueden generar respuestas erróneas. Aunque los desarrolladores establecen restricciones para promover la inclusividad y prevenir daños, esto causa que, en ocasiones, las IA generativas produzcan resultados poco realistas o simplemente absurdos”. Es decir, no se trata sólo de incluir datos de personas fenotípicamente diversas, sino de buscar un equilibrio, quizá imposible de conseguir, entre inclusión y verosimilitud.

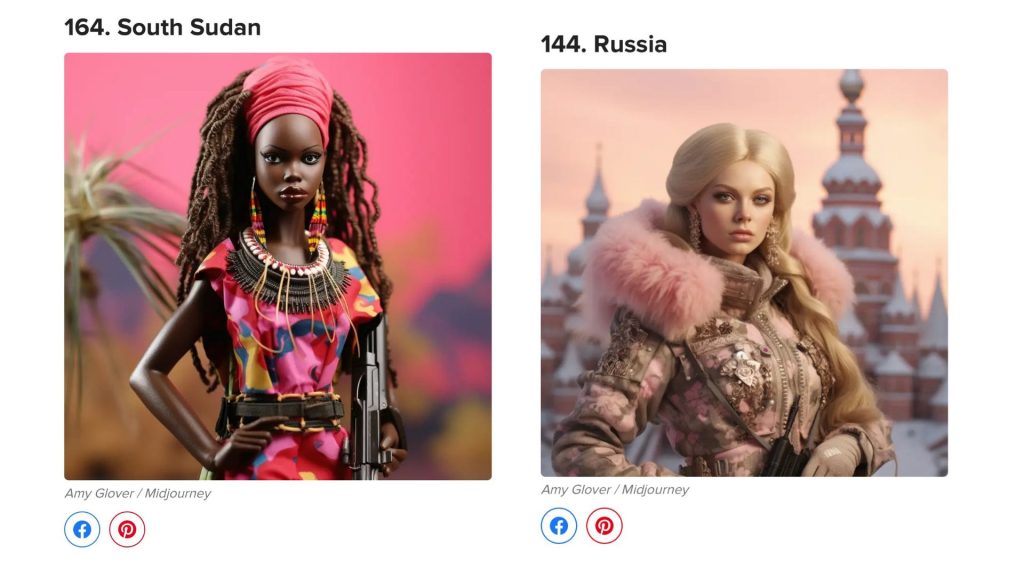

Por ejemplo, cuando se buscan muñecas Barbie de diferentes países por medio de IA generativa de imágenes, la indumentaria que presentan puede variar y en algunos casos caer en estereotipos racistas, especialmente con Barbies que representan países africanos, que pueden aparecer con atuendos asociados a conflictos armados. Este fenómeno no se debe a la escasez de datos sobre personas racializadas, sino a la forma en que estas personas son representadas en Internet, donde existe una sobrerrepresentación de imágenes de individuos racializados en contextos de violencia.

Sin embargo, depurar internet de estos prejuicios es prácticamente imposible, ¿cómo pedirle a la IA que no tenga sesgos si vivimos en una sociedad estructuralmente racista?

El desarrollo tecnológico resuena con las dinámicas de poder y recursos, planteando una compleja interacción donde la innovación se enlaza estrechamente con el acceso y control de recursos. Como apuntan De Brigard, Gutiérrez y Montenegro, este control no solo demuestra la capacidad de influir sino también subraya el poder inherente en la posesión y manejo de la tecnología. El proceso desde la conceptualización hasta la realización de la tecnología no es trivial, englobando un espectro amplio que va desde la inversión en materiales hasta la formación de capital humano y la infraestructura necesaria, todo lo cual destaca la íntima relación entre tecnología, poder y sociedad.

¿Y entonces? ¿Es racista la IA?

Imagina ser una mujer afrodescendiente, ansiosa por explorar tu apariencia en el vibrante escenario de los años 80. A pesar de tus dudas sobre el uso de datos biométricos, decides probar una herramienta de inteligencia artificial. Visualiza, entonces, el momento en que comprendes que, ya sea en los 80 o en 2024, en el ámbito digital o el real, ser una mujer afrodescendiente conlleva retos crecientes. Te percatas de que no es pragmático esperar que la inteligencia artificial elimine los sesgos arraigados; sus defectos no impactan a todxs por igual. Aunque los desarrolladores y creadores tengan buenas intenciones, existe un riesgo tangible de crear algoritmos teñidos de racismo. Eres consciente de que anticipar resultados exentos de prejuicios raciales es irreal en una sociedad que todavía enfrenta estas cuestiones. A menudo, parece que todo cambia solo para permanecer igual.

- Al momento de ofrecer esta entrevista, Juan de Brigard trabajaba como coordinador de la línea de Autonomía y Dignidad en la Fundación Karisma. ↩︎